O avanço dos agentes de IA dá um salto importante com o lançamento do Gemini Robotics 1.5 e do Gemini Robotics‑ER 1.5, da Google DeepMind. A novidade integra planejamento multimodal, uso de ferramentas externas e controle motor preciso para permitir que robôs executem tarefas do mundo real de forma mais autônoma, segura e generalizável. Em termos práticos: a IA deixa de apenas “descrever” ou “simular” e passa a perceber, decidir e agir no ambiente físico, conectando visão, linguagem e ação.

Dois modelos, um agente completo

Gemini Robotics‑ER 1.5: planejamento e raciocínio incorporado

O Gemini Robotics‑ER 1.5 atua como o cérebro estratégico do agente. Ele observa a cena (vídeo, imagens, contexto), entende instruções em linguagem natural, decompõe objetivos em passos e pode usar ferramentas externas quando necessário (por exemplo, consultar informações na web) para tomar decisões mais informadas. O modelo acompanha o progresso, ajusta o plano conforme o feedback do ambiente e mantém a execução segura e consistente.

Gemini Robotics 1.5: visão‑linguagem‑ação para controle de robôs

O Gemini Robotics 1.5 é um modelo de visão‑linguagem‑ação (VLA) que transforma contexto visual e instruções em comandos de controle para robôs. Ele “pensa antes de agir”, o que significa que faz uma etapa de raciocínio interno antes de gerar movimentos, favorecendo decisões mais robustas em tarefas multi‑etapas, com manipulação fina e adaptação às variações do ambiente.

O que o sistema já demonstra

Nas demonstrações da DeepMind, o agente combina percepção e planejamento para executar sequências complexas com consciência de contexto. Exemplos incluem:

- Organização doméstica com múltiplos passos, como separar itens por categorias e posicioná‑los nos locais certos.

- Preparação de tarefas condicionadas a informações externas, usando ferramentas (por exemplo, consultar dados relevantes para decidir o que levar ou como embalar).

- Procedimentos que respeitam regras e restrições do mundo real, como instruções locais (padrões de descarte/reciclagem) e condicionais de segurança.

Esses cenários mostram a transição de uma IA passiva para um agente encarnado (embodied) capaz de perceber, planejar e executar ações no mundo físico.

Por que isso importa

- Produtividade e utilidade real: agentes podem assumir tarefas repetitivas, demoradas ou de difícil padronização, da casa à indústria leve.

- Generalização: o sistema busca transferir habilidades aprendidas para diferentes tipos de robôs e contextos, reduzindo a dependência de customizações caso a caso.

- Alinhamento e segurança: com planejamento explícito e camadas de checagem, o agente torna suas intenções auditáveis, permitindo governança e intervenção humana.

- Integração de ferramentas: ao consultar fontes externas quando precisa, o agente age com mais conhecimento de causa, sem depender apenas de memória interna.

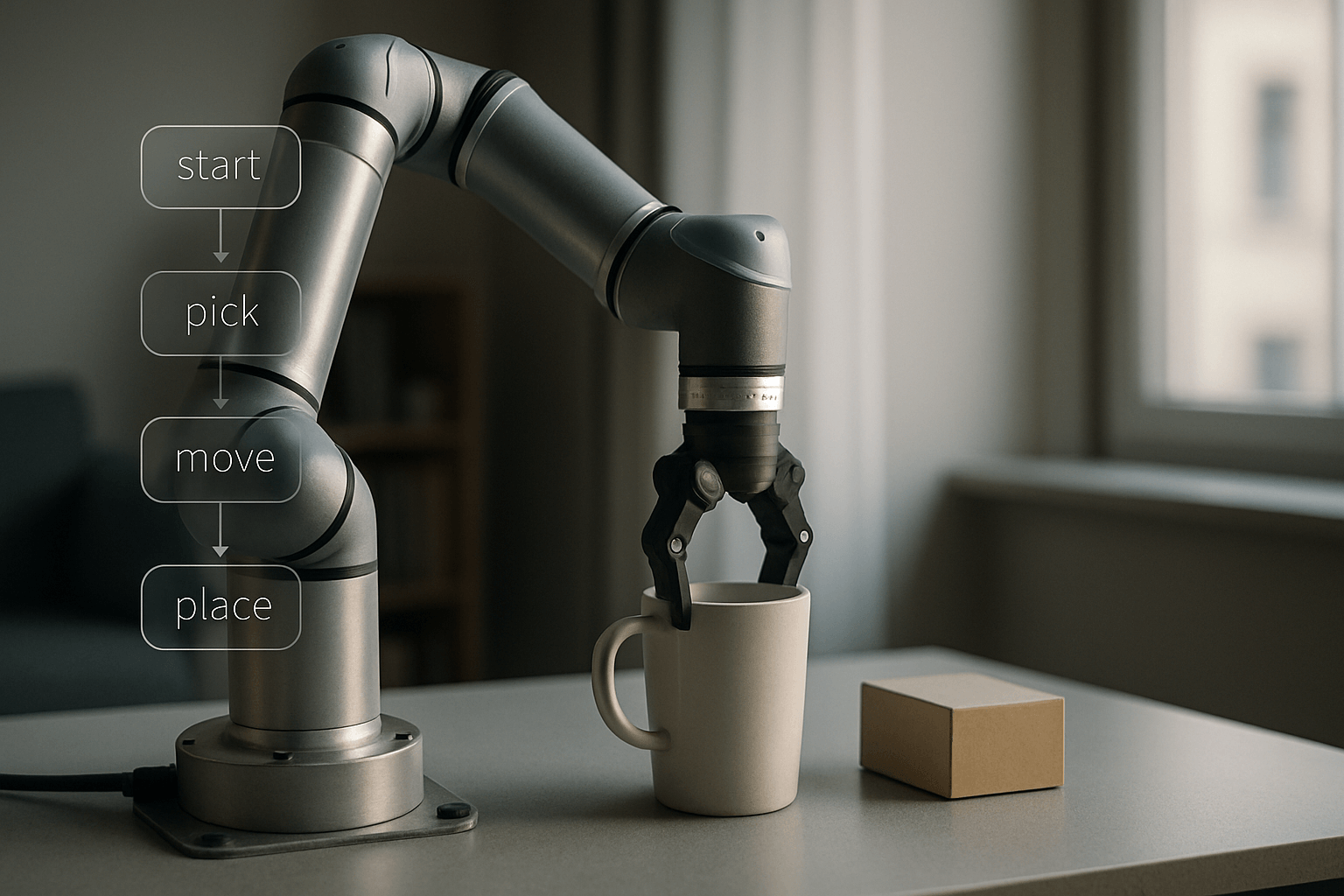

Como funciona: pipeline em alto nível

- Percepção multimodal: visão e linguagem são combinadas para interpretar a cena e a intenção do usuário.

- Raciocínio e decomposição: o Robotics‑ER 1.5 divide a meta em sub‑tarefas e define critérios de sucesso.

- Uso de ferramentas: quando necessário, o agente chama serviços externos (por exemplo, pesquisa) para complementar o contexto.

- Execução: o Gemini Robotics 1.5 converte cada sub‑tarefa em comandos motores consistentes com o contexto visual.

- Feedback e replanejamento: o agente avalia resultados, corrige rotas e previne erros cumulativos.

Transferência de movimento entre robôs

Um destaque é a capacidade de transferência de habilidades entre diferentes formatos de hardware. Em vez de treinar cada robô do zero, o sistema busca portar políticas e movimentos entre braços robóticos, manipuladores e plataformas distintas. Isso acelera a adoção, reduz custo de coleta de dados e facilita levar avanços do laboratório para aplicações reais.

Segurança, testes e governança

A DeepMind enfatiza camadas de segurança e avaliação. Entre os elementos citados:

- Avaliação sistemática: atualização de seu conjunto de testes de segurança para agentes robóticos (por exemplo, benchmark ASIMOV), cobrindo cenários de risco e falhas potenciais.

- Planejamento verificável: o agente explicita passos e condições, permitindo auditoria, aprovação humana e bloqueios quando necessário.

- Políticas de intervenção: limites e mecanismos de parada para assegurar que o robô opere dentro de zonas seguras e sob supervisão.

Disponibilidade e como experimentar

- Gemini Robotics‑ER 1.5: disponível via Gemini API no Google AI Studio, voltado a planejamento, raciocínio embutido e uso de ferramentas.

- Gemini Robotics 1.5: inicialmente acessível para parceiros selecionados, focado na camada de controle visão‑linguagem‑ação.

Para desenvolvedores, o caminho prático envolve conectar o agente ao seu robô, definir tarefas em linguagem natural, fornecer demonstrações quando necessário e criar checagens de segurança adequadas ao ambiente. A integração com ferramentas externas permite ampliar a autonomia com contexto atualizado (por exemplo, consultar informações relevantes ao plano).

Termos‑chave

- Agente de IA: sistema que percebe, decide e age de forma contínua em direção a um objetivo.

- Embodied AI (IA encarnada): IA que interage fisicamente com o mundo, geralmente por meio de robôs.

- VLA (visão‑linguagem‑ação): classe de modelos que conectam percepção visual e linguagem a comandos motores.

- Uso de ferramentas (tool use): capacidade de acionar serviços externos (como pesquisa) para melhorar o planejamento e a execução.

Implicações

A convergência entre planejamento multimodal e controle motor abre caminho para robôs mais úteis, adaptáveis e confiáveis. Ao tornar o raciocínio do agente observável e integrável a ferramentas externas, o Gemini Robotics 1.5 cria um elo entre a IA generativa e a robótica prática. Isso pode acelerar aplicações em logística leve, apoio doméstico, manutenção e serviços, desde que acompanhadas por avaliações rigorosas, governança e desenho responsável. O passo dado pela DeepMind aponta para uma próxima fase em que agentes de IA deixam a tela e passam a colaborar, com segurança, no mundo físico.

Fonte: https://deepmind.google/discover/blog/gemini-robotics-15-brings-ai-agents-into-the-physical-world/