Por que simplificar o stack de IA importa agora

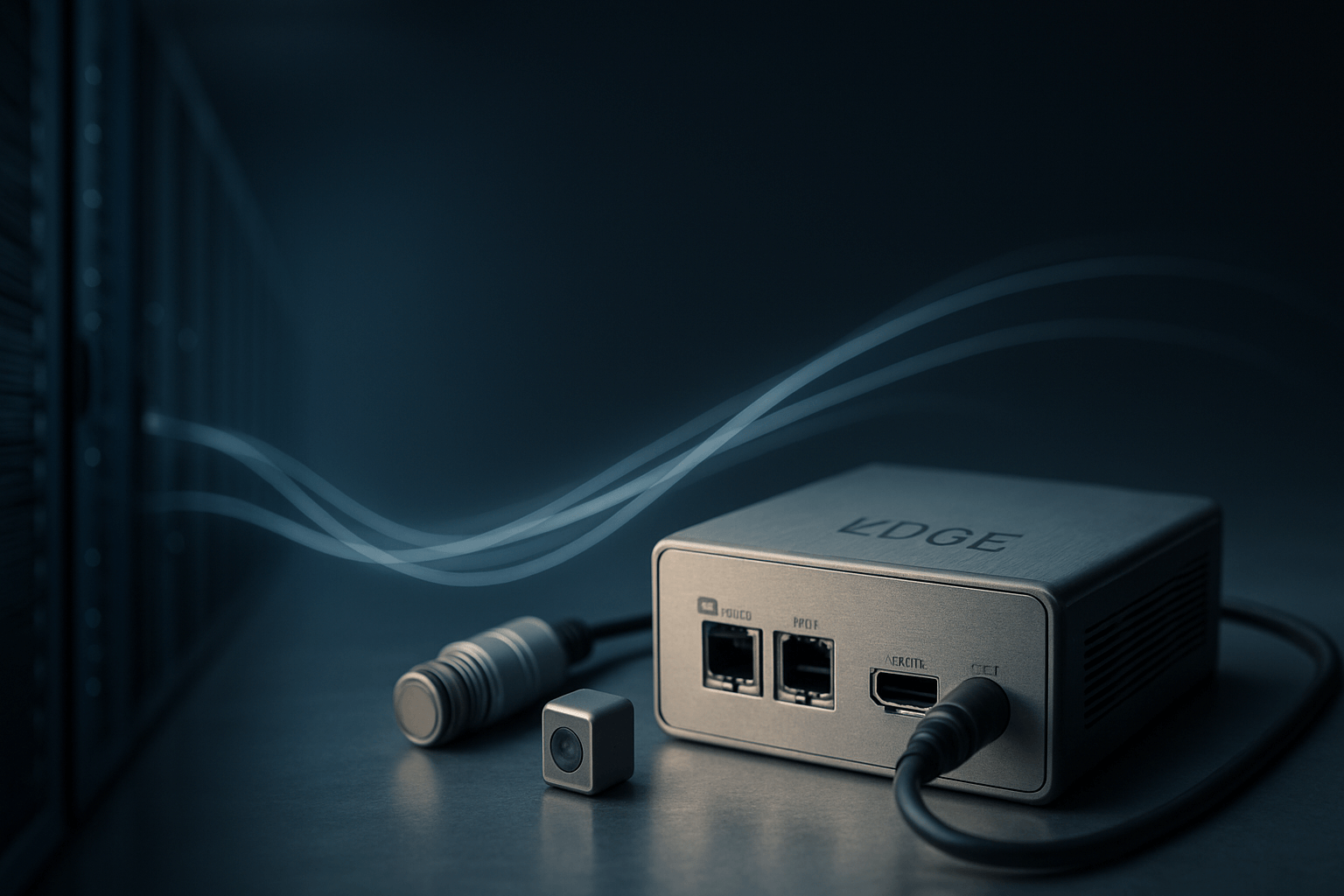

Levar inteligência artificial do laboratório para a produção, em escala, exige reduzir fricções técnicas entre a nuvem e a borda (cloud to edge). Um stack de IA simplificado — com ferramentas, APIs e práticas consistentes — acelera o ciclo de vida de modelos, diminui custos, reduz latência e aumenta a portabilidade entre diferentes hardwares e ambientes. Em conteúdo publicado no VentureBeat, patrocinado pela Arm, a tese central é clara: unificar e simplificar o stack é o caminho para uma IA escalável, eficiente e realmente portátil do cloud ao edge.

O que é o “stack de IA” e por que ele ficou complexo

O stack de IA reúne camadas que vão de dados e treinamento ao deployment e observabilidade. Com a explosão de modelos, aceleradores e serviços, a diversidade cresceu — e a complexidade também. O resultado: integrações frágeis, retrabalho entre times, dependência de fornecedores e custos imprevisíveis.

Componentes típicos do stack

- Dados e features: ingestão, limpeza, versionamento e governança.

- Treinamento e ajuste fino: pipelines, recursos de computação e gerenciamento de experimentos.

- Otimização e preparação: compressão, quantização, compilação e checagens de conformidade.

- Inferência: runtimes, escalonamento, caching e controle de latência.

- MLOps e observabilidade: monitoramento, A/B tests, logging, métricas de qualidade e segurança.

- Segurança e conformidade: privacidade, isolamento, auditoria e políticas de ciclo de vida.

Principais dores de um stack fragmentado

- Portabilidade limitada: modelos e pipelines que funcionam na nuvem não rodam bem na borda (e vice-versa).

- Lock-in tecnológico: dependência de SDKs e APIs proprietárias impede evolução e negociação de custos.

- Retrabalho e time-to-market maior: cada ambiente exige adaptações, testes e validações diferentes.

- Custos de operação e manutenção: toolchains redundantes elevam o TCO e dificultam governança.

- Riscos de performance e qualidade: variação de latência, consumo de energia e acurácia entre alvos.

Princípios para um stack de IA simples, portátil e escalável

1) Toolchain unificado do cloud ao edge

Adote um conjunto único de ferramentas e práticas que cubra desde o treinamento até a inferência, com o mínimo de “adaptações por alvo”. O ideal é ter uma experiência de desenvolvimento consistente — empacotar, testar e implantar com o mesmo pipeline, variando apenas configurações específicas de hardware.

2) Padronização de artefatos e interfaces

Formatos, contratos de API e metadados padronizados reduzem surpresas na produção. Ao padronizar como modelos, dependências e políticas são descritos, fica mais simples garantir compatibilidade entre infra de nuvem e dispositivos de borda.

3) Runtimes e compilação otimizados para múltiplas arquiteturas

Portabilidade real requer que o runtime e a etapa de compilação saibam tirar proveito de diferentes arquiteturas (CPUs, NPUs, GPUs, microcontroladores) sem reescrever o modelo. O stack deve oferecer otimizações automáticas, respeitando limites de memória, energia e latência na borda.

4) Observabilidade e MLOps consistentes

Métricas de qualidade, performance e custo precisam ser comparáveis entre cloud e edge. Logs estruturados, tracing e dashboards unificados permitem detectar regressões e aplicar correções rapidamente, mantendo SLAs e SLOs.

5) Segurança por padrão

Criptografia, assinatura de modelos, controle de versões e políticas de acesso finas são essenciais para cumprir requisitos regulatórios e proteger propriedade intelectual. No edge, incluir “secure boot”, atestação e proteção de dados sensíveis em repouso e em trânsito.

Benefícios práticos de um stack simplificado

- Menos tempo entre POC e produção: equipes focam no valor do caso de uso, não em integrações pontuais.

- Portabilidade real: mover cargas entre nuvem, on-prem e edge conforme custo, latência e disponibilidade.

- Melhor TCO: menos ferramentas duplicadas, pipelines reaproveitáveis e governança mais simples.

- Desempenho previsível: otimizações consistentes para cada alvo, com SLOs claros.

- Escalabilidade: implantar em milhões de dispositivos com processos repetíveis e auditáveis.

Cloud to edge: quando rodar onde

Decidir a localização da inferência é uma escolha de arquitetura: rodar na nuvem maximiza elasticidade e facilita atualizações frequentes; executar na borda reduz latência, tráfego de dados e dependência de conectividade. Um stack simples permite escolher dinamicamente conforme o caso de uso, inclusive modelos híbridos (pré-processamento no edge e enriquecimento na nuvem).

Critérios de decisão

- Latência e confiabilidade: aplicações em tempo quase real favorecem a borda.

- Privacidade e custo de dados: dados sensíveis e alto volume incentivam processamento local.

- Frequência de atualização: atualizações constantes podem se beneficiar de pipelines cloud-first.

- Energia e hardware disponível: dispositivos com restrições demandam otimizações agressivas.

Boas práticas para iniciar (ou migrar) sem traumas

- Mapeie o inventário: modelos, dependências, formatos e requisitos de cada caso de uso.

- Defina contratos claros: entradas/saídas, SLAs de latência e requisitos de segurança.

- Escolha um pipeline único: um único conjunto de CI/CD e MLOps para cloud e edge.

- Automatize otimizações: quantização, compressão e empacotamento como etapas padrão.

- Observabilidade desde o dia 0: logging e métricas unificadas já no ambiente de staging.

- Planeje rollback e canary: especialmente crítico ao atualizar dispositivos remotos na borda.

Implicações para times de negócios e tecnologia

Para o negócio, simplificar o stack de IA acelera time-to-value e reduz riscos de escala. Para engenharia, significa menos retrabalho e mais foco em qualidade e confiabilidade. Para segurança e compliance, um único caminho de auditoria simplifica evidências e relatórios. Em última instância, a simplificação cria uma base para portabilidade: mover workloads de forma soberana, evitando lock-in e aproveitando o melhor de cada ambiente.

Termos essenciais (em linguagem direta)

- Portabilidade: capacidade de rodar o mesmo modelo em diferentes hardwares/ambientes sem reescritas profundas.

- Inferência: etapa em que o modelo já treinado gera previsões em produção.

- Borda (edge): dispositivos e gateways próximos à fonte dos dados, com recursos limitados e baixa latência.

- Toolchain: conjunto de ferramentas, bibliotecas e processos usados no ciclo de vida de IA.

O recado estratégico é simples: padronize artefatos, unifique pipelines e escolha runtimes que entendam a diversidade de hardware. Assim, sua IA escala do cloud ao edge com previsibilidade, segurança e eficiência.

Fonte: https://venturebeat.com/ai/simplifying-the-ai-stack-the-key-to-scalable-portable-intelligence-from