O que aconteceu e por que importa

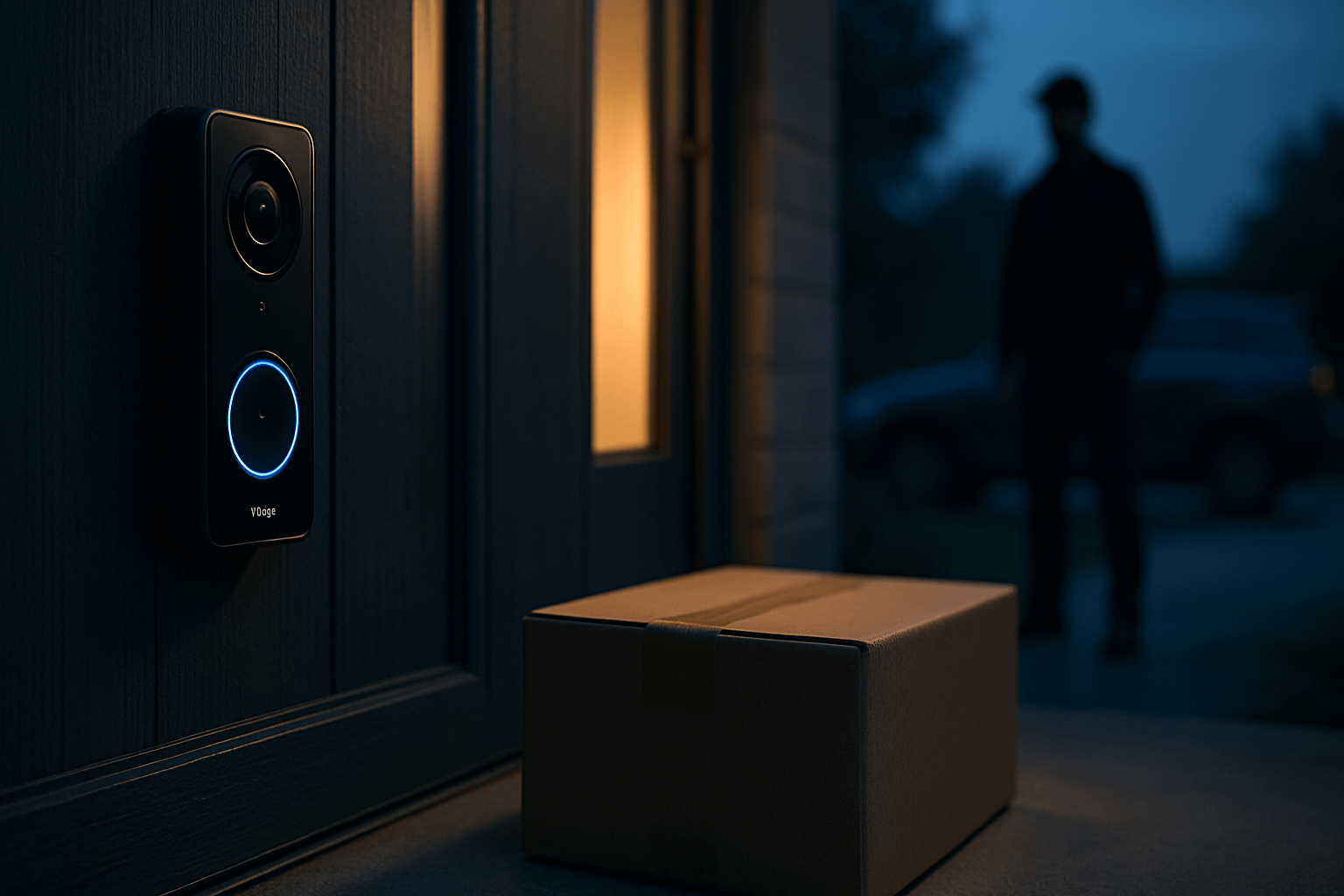

A Anker, por meio de sua marca Eufy, ofereceu dinheiro a proprietários de câmeras domésticas para compartilharem vídeos com o objetivo de treinar recursos de inteligência artificial. Segundo o TechCrunch, a campanha pagava US$ 2 por vídeo, com foco em cenas relacionadas à segurança residencial — como furtos de pacotes e tentativas de abrir portas de carros — e chegou a incentivar a produção de clipes encenados. A iniciativa levanta questões centrais de privacidade, consentimento e transparência na coleta de dados de vigilância para fins de IA.

Embora a prática de usar dados do mundo real para aprimorar modelos seja comum no setor, a combinação de câmeras domésticas, imagens potencialmente sensíveis e incentivos financeiros reabre um debate importante: até que ponto usuários entendem e consentem com o uso de imagens de suas casas, vizinhos e visitantes para treinar algoritmos?

Como funcionava a oferta de vídeos

De acordo com a reportagem, a Eufy convidou usuários a enviar gravações específicas, incluindo incidentes de segurança e cenas simuladas. O pagamento por clipe era de US$ 2, um valor pequeno, mas que, em volume, pode atrair muitos envios. A iniciativa teria utilizado um processo simples de submissão online e pagamento digital, visando aumentar rapidamente o conjunto de dados necessários ao treinamento de modelos de visão computacional.

O detalhe sobre vídeos encenados chama atenção: quando empresas de tecnologia aceitam material simulado, elas buscam cobrir cenários raros ou difíceis de capturar no cotidiano, o que pode acelerar o aprendizado do modelo. Ao mesmo tempo, esse tipo de dado pode introduzir vieses se as encenações não refletirem fielmente a realidade, afetando a precisão em situações do mundo real.

Programas de doação e gamificação

Além do pagamento em dinheiro, a Eufy também promoveu um programa de “doação de vídeos” dentro do aplicativo, com recompensas não monetárias (como selos, eventuais brindes e reconhecimento em um “Honor Wall”). Essa abordagem de gamificação costuma estimular a participação contínua e a criação de um senso de comunidade, mas também reforça a necessidade de políticas claras sobre consentimento, anonimização e finalidade de uso dos dados.

Entenda os termos: como vídeos treinam IA

- Treinamento supervisionado: os modelos aprendem a reconhecer padrões a partir de exemplos rotulados (por exemplo, “pessoa puxando a maçaneta de um carro”).

- Dados sensíveis de vigilância: gravações domésticas podem revelar rotinas, visitas e informações sobre terceiros que não aceitaram ser filmados para fins de treino.

- Generalização e viés: se o conjunto de dados não for diversificado ou contiver encenações artificiais, o modelo pode errar em contextos diferentes do material de treinamento.

Privacidade, consentimento e expectativa legítima

O uso de vídeos de residências para IA exige atenção redobrada ao consentimento informado. Mesmo quando o proprietário concorda, pessoas capturadas nas imagens — como vizinhos, entregadores e visitantes — podem não ter ciência de que sua imagem poderá treinar algoritmos. Isso cria zonas cinzentas legais e éticas, sobretudo quando as imagens captam áreas semi-públicas (calçadas, ruas) a partir de propriedades privadas.

Transparência sobre a finalidade (treinamento de IA), duração de retenção, possibilidade de exclusão e eventual compartilhamento com terceiros é essencial. Também é recomendável minimizar a exposição de dados identificáveis, aplicar técnicas de anonimização quando possível e deixar claro se os vídeos poderão ser usados além da detecção de eventos de segurança.

Contexto: histórico de confiança e segurança

O debate ganha peso adicional porque confiança é um ativo crítico para marcas de câmeras de segurança. Nos últimos anos, já houve controvérsias públicas envolvendo práticas de segurança e criptografia no ecossistema de câmeras conectadas. O caso atual, ainda que focado em um programa de coleta remunerada e de doações, reforça a necessidade de comunicação clara sobre como o material é protegido e tratado durante o ciclo de vida do dado (coleta, armazenamento, treinamento e descarte).

Riscos e implicações para usuários e mercado

- Exposição involuntária: terceiros podem aparecer em vídeos enviados para treinamento sem terem consentido explicitamente.

- Reidentificação: mesmo quando não há nomes, detalhes visuais (placas, fachadas, hábitos) podem permitir identificar pessoas ou locais.

- Vieses no modelo: clipes encenados, se mal balanceados, podem distorcer a performance da IA em cenários reais.

- Superdependência da IA: expectativas infladas sobre “detecção inteligente” podem levar a falsos positivos/negativos, com impacto em segurança e confiança do consumidor.

Boas práticas para quem usa câmeras Eufy (e similares)

- Revise as configurações: verifique permissões de compartilhamento no app e desative opções de envio automático que você não deseja usar.

- Entenda a política: leia os termos relacionados a programas de doação e remuneração; confirme finalidade, retenção e se há opção de excluir seus dados do treinamento.

- Evite identificar terceiros: se optar por participar, procure não enviar material com dados pessoais sensíveis de outras pessoas.

- Segurança da conta: ative autenticação em dois fatores, use senhas fortes e atualize o firmware para reduzir riscos de acesso indevido.

- Zona de captura: ajuste ângulos e máscaras de privacidade para minimizar a filmagem de áreas públicas ou propriedades de vizinhos.

O que as empresas precisam fazer melhor

Quando um fabricante coleta vídeos para IA, deve comunicar com clareza: propósito, base legal, medidas de proteção, possibilidade de revogação do consentimento e impactos esperados no produto. Devem ser oferecidos controles granulares ao usuário (opt-in, exclusão, transparência sobre auditorias), além de auditorias independentes que validem governança de dados e mitigação de vieses. Esse nível de transparência é crucial tanto para atender legislações de privacidade quanto para preservar a confiança do consumidor.

O que fica de lição

A oferta de US$ 2 por vídeo para treinar modelos de segurança evidencia como dados do mundo real tornaram-se a “matéria-prima” da IA moderna. Para o usuário, a decisão de participar ou não deve considerar privacidade, expectativas da vizinhança e compreensão do uso futuro das imagens. Para o mercado, o episódio reforça a urgência de políticas de dados robustas e comunicação inequívoca. Quanto mais claro for o pacto de transparência entre empresas e consumidores, mais sustentável será a evolução da IA em produtos de segurança doméstica.