O que está em jogo: a confiabilidade dos agentes de IA nas empresas

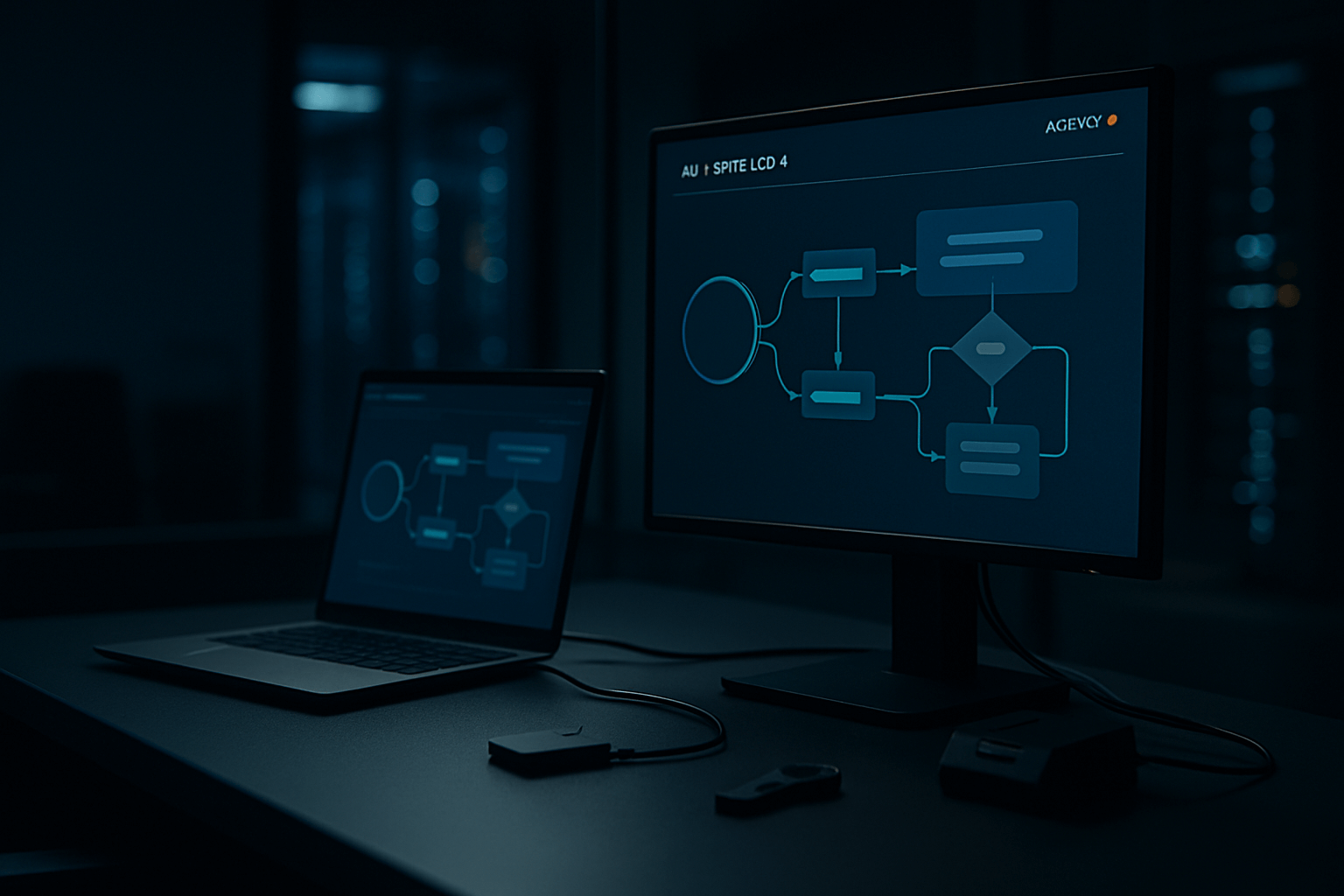

Agentes de IA prometem automatizar fluxos de trabalho complexos, integrar-se a sistemas corporativos e executar tarefas de ponta a ponta com mínima intervenção humana. O grande obstáculo sempre foi a confiabilidade: como garantir que um agente execute a ação certa, no sistema certo, com rastreabilidade, segurança e consistência dignas de produção? É esse o foco da reportagem da VentureBeat sobre a AUI e seu agente Apollo-1, que coloca a confiabilidade no centro da proposta para uso empresarial.

O que a reportagem da VentureBeat revela

Segundo a VentureBeat, uma startup em modo stealth, a AUI, apresenta o Apollo-1 — um agente de IA voltado ao uso corporativo, cuja proposta é enfrentar o problema da confiabilidade em ambientes de missão crítica. A matéria contextualiza a ambição: tornar agentes realmente utilizáveis em escala empresarial, reduzindo falhas, aumentando previsibilidade e melhorando a governança de ponta a ponta. Trata-se de um movimento relevante em um momento em que companhias buscam transformar pilotos em operações contínuas e auditáveis.

Quem é a AUI e o que é o Apollo-1?

Com base no que é descrito, a AUI opera em modo stealth e apresenta o Apollo-1 como um agente de IA desenhado para cenários de empresa. Em termos práticos, um agente empresarial é um sistema que combina modelos de linguagem, integrações com ferramentas e dados corporativos, políticas de segurança e monitoramento para cumprir objetivos específicos (por exemplo, triagem de demandas internas, atualização de registros em sistemas, análise de documentos e geração de relatórios). O ponto-chave, de acordo com a reportagem, é a ênfase do Apollo-1 na confiabilidade operacional, elemento crítico para sair do laboratório e ir para produção.

Por que agentes falham em produção

- Alucinações e imprecisão: modelos podem gerar respostas plausíveis, porém incorretas, sem mecanismos de validação.

- Orquestração frágil: sequências de chamadas a ferramentas e APIs quebram sob variações de entrada, timeouts ou mudanças de esquema.

- Falta de rastreabilidade: decisões sem trilha de auditoria tornam impossível investigar incidentes.

- Segurança e compliance: riscos de vazamento de dados, violações de permissão e uso indevido de credenciais.

- Contexto inconsistente: perda ou confusão de estado entre etapas leva a ações erradas ou duplicadas.

- Observabilidade limitada: ausência de métricas e logs estruturados impede melhoria contínua e SLOs significativos.

- Experiência do usuário: sem UX adequada, agentes pedem informações redundantes, fazem loops ou exigem intervenção constante.

Pilares de confiabilidade para um agente de IA corporativo

- Planejamento robusto: decomposição de tarefas em etapas claras, com verificação de pré-condições e metas bem definidas.

- Orquestração determinística onde importa: controlar o que deve ser previsível (sequenciamento, validação de esquema, tipos) e isolar o que é probabilístico (gerações e classificações).

- Ferramentas seguras e testadas: integrações com APIs e sistemas corporativos com contratos de entrada/saída, testes automatizados e sandbox.

- Recuperação de contexto (RAG) responsável: preenchimento de lacunas com dados confiáveis, versionados e com controles de acesso.

- Observabilidade e telemetria: logs estruturados, spans de execução, métricas de sucesso/falha, latência por etapa e amostragem de qualidade.

- Governança e políticas: limites de escopo, aprovação humana quando necessário, registro de decisões e trilhas de auditoria.

- Avaliação contínua: testes offline (conjuntos de avaliação) e online (A/B, shadow, canary) com feedback humano e métricas de negócio.

- UX e handoff humano: desenho de interfaces que informam estado, incerteza e permitem intervenção rápida e segura.

Como avaliar soluções como o Apollo-1

A reportagem coloca holofotes sobre confiabilidade. Para equipes técnicas e de negócio, segue um checklist prático ao comparar agentes empresariais:

- Definição de sucesso: o fornecedor explicita metas mensuráveis (ex.: taxa de conclusão correta por fluxo)?

- Contratos e validações: cada ferramenta tem esquemas rigorosos, validações e tratamento de erro padronizados?

- Gestão de estado: existe representação explícita do estado e mecanismos para retomada após falhas?

- Auditoria de ponta a ponta: é possível reproduzir uma execução e entender por que cada passo foi tomado?

- Segurança e controle de acesso: o agente opera com least privilege, rotação de credenciais e segregação de ambientes?

- Observabilidade nativa: logs, métricas e traces estão disponíveis e integráveis a ferramentas já usadas (ex.: SIEM, APM)?

- Avaliação e melhoria: há pipeline para testes regressivos, comparação de versões e coleta de feedback humano?

- Experiência do usuário: a interface comunica limitações, incertezas e oferece caminhos de correção sem atrito?

Impactos para CIOs, times de dados e produto

Para CIOs e líderes de plataforma, a proposta de agentes mais confiáveis sinaliza um avanço do estágio de prova de conceito para produção. O ganho potencial inclui automação segura de rotinas, aceleração de atendimento interno, melhor qualidade de dados operacionais e time-to-value menor para integrações. Para times de dados, padronizar telemetria e avaliações permite treinar, comparar e promover versões com menos risco. Para produto e UX, o desenho centrado em estado, feedback e intervenção humana define a diferença entre uma experiência “mágica” e uma frustração.

Casos de uso típicos onde a confiabilidade é crucial

- Atendimento interno e RH: triagem e resolução de solicitações com integrações a sistemas de identidade e folha de pagamento.

- Backoffice financeiro: reconciliação, coleta de documentos e atualização de registros com validações rigorosas.

- Suporte a TI: abertura, atualização e fechamento de tickets com ações automatizadas em ferramentas de gerenciamento.

- Operações comerciais: preparação de propostas, análise de contratos e sincronização com CRM/ERP.

- Compliance e auditoria: geração de relatórios com trilha de evidências e controles de acesso por função.

Riscos e limitações que permanecem

Mesmo com uma arquitetura orientada à confiabilidade, riscos não desaparecem: dependência de modelos de base, mudanças nas APIs, deriva de dados e cenários não previstos exigem defesa em camadas. Transparência sobre limitações e rotas de correção — incluindo aprovação humana e reversão segura — continua indispensável.

O que observar a seguir

A cobertura da VentureBeat sugere que a próxima onda de agentes se organizará em torno de confiabilidade, rastreabilidade e governança. Para o mercado, os sinais a acompanhar incluem maturidade das integrações, qualidade da observabilidade nativa, clareza de contratos de ferramentas e evidências de desempenho consistente em ambientes reais. Em última análise, a adoção dependerá de provar, na prática, que agentes como o Apollo-1 mantêm alta taxa de acerto, reduzem retrabalho e operam com a disciplina que as empresas exigem.

Fonte: https://venturebeat.com/ai/has-this-stealth-startup-finally-cracked-the-code-on-enterprise-ai-agent